各類Loss Function 之間有什麼不同之處?

損失函數基本上可以分成兩個不同的問題面向,分別是分類問題(Classification)以及回歸問題(Regression),下面我想跟大家介紹,兩種問題各自有適合的損失函數,而我們都是目標就是最小化兩種問題的損失函數。

回答列表

-

2021/10/20 下午 02:44Chili贊同數:0不贊同數:0留言數:0

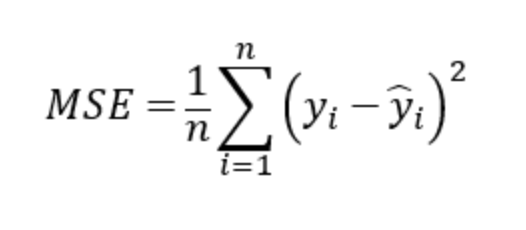

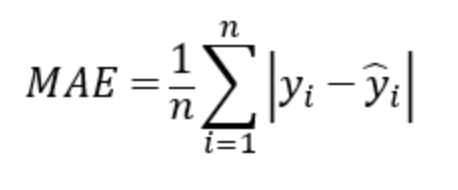

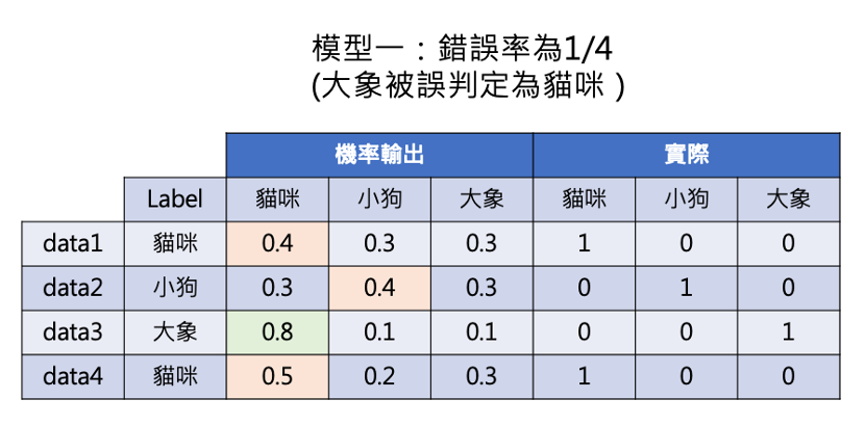

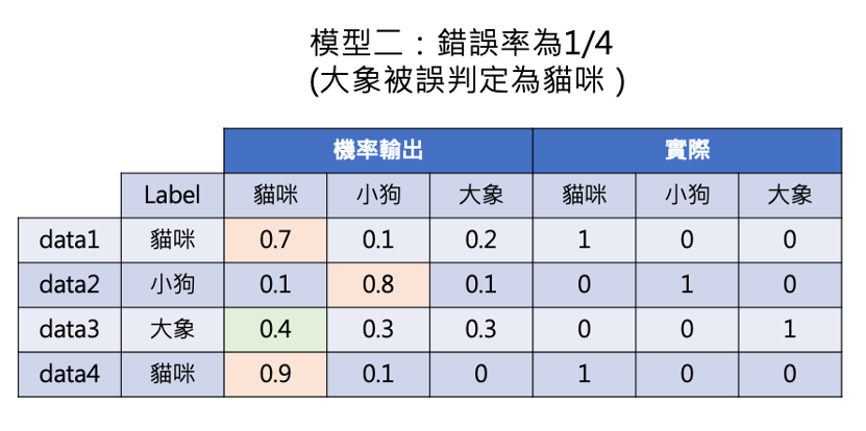

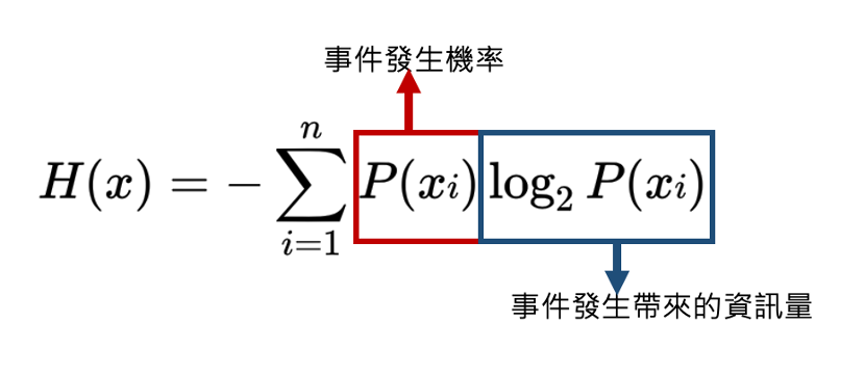

* Regression Problem: 針對回歸問題,我們會希望模型預測的結果與我們實際的值相似,但現實上,不太可能做到完全相似,因此實際值與預測值的差即為殘差(residual),而損失函數的作用就是計算Residual的大小,一個好的模型,損失函數的值會越小 * 回歸問題常用的損失函數:MSE 、 MAE 針對回歸問題,我們最常用MSE & MAE作為損失函數,兩者都可以輕易地幫助我們觀察到一個模型的好壞。  MSE(Mean Squared Error)的算法是從我們的所有數據中 1. 拿預測的值(predictd value)與真實數據(labeled value)相減 2. 所有的相減值皆平方(避免誤差正負相消),並取總和 3. 再除以總數量平均  MAE(Mean Absolute Error)的算法是從我們的所有數據中 1. 拿預測的值(predictd value)與真實數據(labeled value)相減 2. 所有的相減值取絕對值,並取總和 3. 再除以總數量平均 --- * Classification Problem 分類問題的目標結果是一個“類別”,並非“連續變數”,因此用MSE來作為損失函數時,表現會非常不好。 舉個例子來說   單從機率表現上,比較兩個模型,可以發現兩模型的錯誤率都為1/4,但模型二的表現明顯優於模型一,因此單看模型的錯誤率作為Loss function或是作為比較的指標化,得到的結果有限,看不太出兩模型的差異,且在學習的過程中,因為單看錯誤率無法得知與正確答案差多少,因此無法得到更好的學習方向。 --- * 回歸問題常用的損失函數:CE(Cross Entropy)  從上面Cross entropy Loss 與輸出機率關係圖可知,當模型輸出的預測機率越接近1時,Loss越小,模型也就越優秀。 簡單來說,以Cross Entropy作為損失函數,更好比較個模型間的優劣,並且更有利於模型之後的學習。 --- 參考資料: https://chih-sheng-huang821.medium.com/機器-深度學習-基礎介紹-損失函數-loss-function-2dcac5ebb6cb https://www.cupoy.com/qa/club/ai_tw/0000016D6BA22D97000000016375706F795F72656C656173654B5741535354434C5542/0000017BA0B0F427000000086375706F795F72656C656173655155455354