【QA】什麼是梯度消失(Gradient Vanishing)與梯度爆炸(Gradient Explored)?

本次想要跟各位探討一下,什麼是梯度消失與梯度爆炸

回答列表

-

2021/09/03 下午 10:48Ray贊同數:0不贊同數:0留言數:0

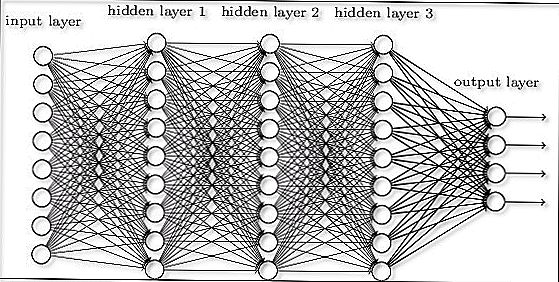

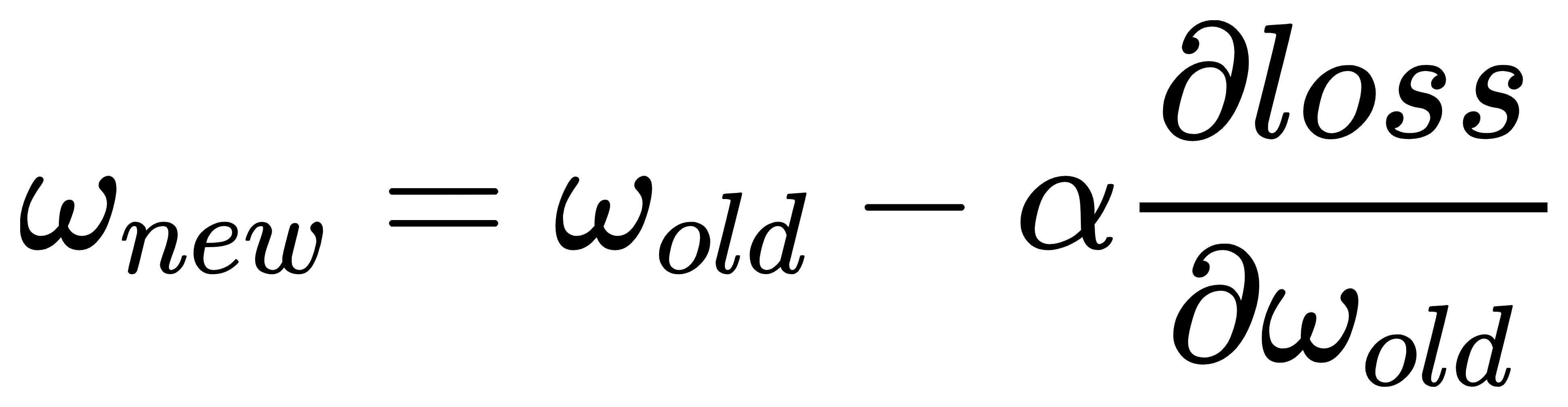

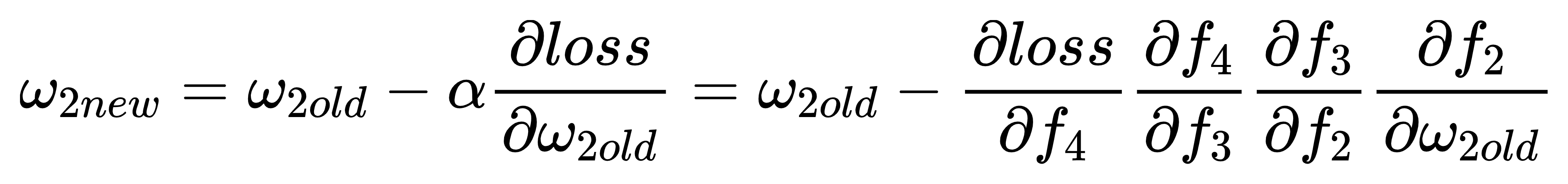

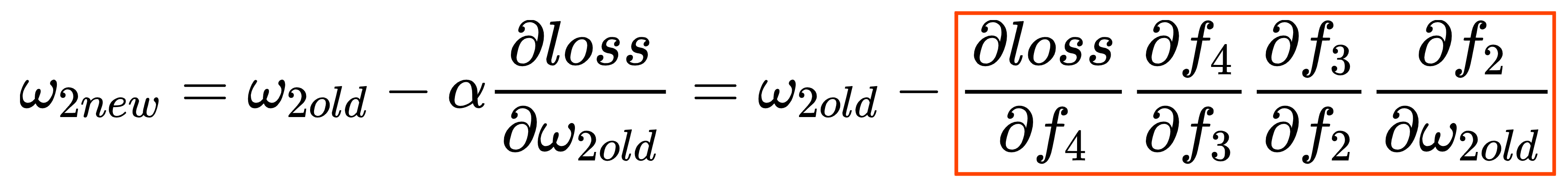

在深度學習神經網絡中,隨著層數的增加,往往會遇到梯度不穩定的問題,而這個問題便是梯度消失以及梯度爆炸。 在神經網絡反向傳播中,當梯度從後往前傳時,梯度不斷減小,最後變為零,此時,淺層的神經網絡權重得不到更新,那麼前面隱藏層的學習速率低於後面隱藏層的學習速率,即隨著隱藏層數目的增加,分類準確率反而下降了。這種現象叫做梯度消失。一旦發生了梯度消失的問題,我們的訓練就很難繼續下去。訓練不再收斂,也就是loss不再下降,準確率過早的無法提高。 以下以使用Sigmoid作為激活函數的深度神經網絡為例:  當神經網絡在進行反向傳播的時候,會根據前向傳播時的預測輸出和目標輸出的誤差,來決定要如何更新網路中的權重,這個誤差就是loss,其權重更新方式如下:  其中alpha為給定學習率,假設今天是要更新第二層,那麼根據反向傳播的連鎖法則(Chain Rule),其數學式如下:  但是在之前的問題[【QA】為什麼使用Relu能夠解決梯度消失?](https://www.cupoy.com/qa/club/ai_tw/0000016D6BA22D97000000016375706F795F72656C656173654B5741535354434C5542/0000017BAA3460330000000F6375706F795F72656C656173655155455354)裡有提到過,Sigmoid其導數的閥值為(0, 0.25),也就是說下圖匡中的每一項其值都不會超過0.25  而隨著層數的增加,匡中的值將會以指數形式越來越小,最後淺層(靠近input層)的權重變動會越來越少,這就是梯度消失;而梯度爆炸則是剛好相反,匡中的每一項其值都大於1,最後匡中的值將隨著層數的增加以指數形式越變越大,越是靠近淺層(靠近input層)的權重變動會越來越大,當權值過大時,神經網絡中淺層比深層的梯度變化更快,就會引起梯度爆炸問題。。 ----------------------------------------------------------------------------------------------- 若是有興趣進一步了解的人可參考以下連結: * [Tutorial 7- Vanishing Gradient Problem](https://www.youtube.com/watch?v=JIWXbzRXk1I) * [神經網絡的梯度消失是什麼?梯度爆炸是什麼?如何解決它們?](https://kknews.cc/zh-tw/code/4zagkvx.html) * [任务54:梯度爆炸和梯度消失](https://www.youtube.com/watch?v=asGJk09usbY)