【QA】什麼是 self-attention??

2021/09/01 下午 03:11

機器學習共學討論版

王健安

觀看數:172

回答數:1

收藏數:0

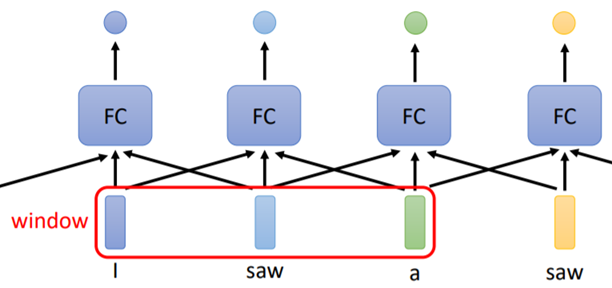

NLP領域中,不論是情感分析、關鍵字提取等任務,都需要一段很長的文字作為訓練資料,且每個字之間都有高度相關性;然而像RNN、LSTM等模型,僅僅考量到順序性的關聯性,並非考量到字與字之間在文章中的關聯性;而self attention就幫為這個領域注入新力量,也成為時下最流行的BERT的其中一個架構,那self attention到底是什麼呢?

回答列表

-

2021/09/01 下午 03:28王健安贊同數:0不贊同數:0留言數:0

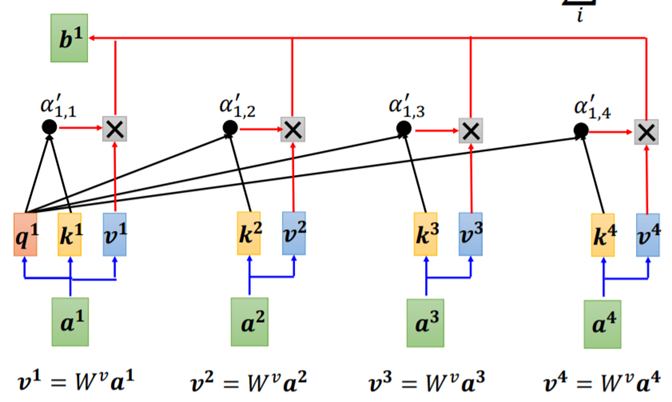

self attention是NLP領域常見的演算法, 完整考量到每個字在一段文字中的上下文關係, 把上下文的資訊一併考量。  演算法的部分, 一開始會將每個字的向量分成q, k以及v, 接著q會與除自己以外的其他字的k相乘, 接著再乘上v,最後再全部相加, 就會得到那個字經過attention的結果。  參考答案: 李弘毅 自注意力機制 (Self-attention) (下) https://www.youtube.com/watch?v=hYdO9CscNes